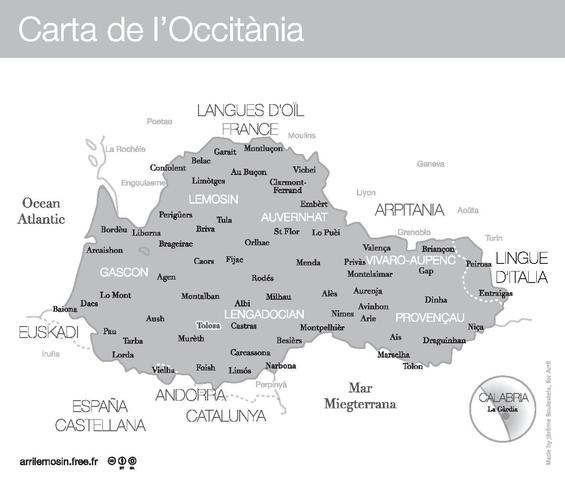

Unterstützung von Regionalsprachen: eine Geschichte der Zusammenarbeit zwischen dem Okzitanischen Kulturinstitut und Wikidata

WMDE allgemein

27. September 2019

Der Beitrag ist auch auf englisch, französisch und okzitanisch erschienen.

Wikidata, die freie, von allen Menschen bearbeitbare Wissensdatenbank, bietet die Möglichkeit, lexikographische Daten zur Beschreibung von Sprachelementen einzugeben. Lo Congrès permanent de la lenga Occitana, eine Institution, die mit Hilfe der Computerlinguistik und der natürlichen Sprachverarbeitung (NLP) dazu beiträgt, das okzitanische Vokabular in das digitale Zeitalter zu bringen, hat die Aufgabe übernommen, okzitanische Wörter (oder Lexeme) in Wikidata zu erstellen.

Der Prozess des digitalen Imports der alten okzitanischen Sprache in Wikidata ist nicht anders als der Bau der befestigten Stadt Carcassonne in Okzitanien – es geht um Bausteine, die die Zeit überdauern.

Um mehr über das Projekt zu erfahren, haben wir mit Aure und Vincent gesprochen, die beide an der Vorbereitung des Imports okzitanischer Wörter in Wikidata beteiligt waren.

Könnten Sie sich und Lo Congrès vorstellen, was sind dort Ihre Aufgaben?

„Lo Congrès permanent de la lenga Occitana“ ist eine wissenschaftliche Institution, die sich zum Ziel gesetzt hat, die Entwicklung des Okzitanischen durch die Schaffung von Werkzeugen zu den verschiedenen Aspekten der okzitanischen Sprache (Lexikographie, Lexikologie, Terminologie, Neologie, Phonologie, Grafik, Grammatik und Toponymie) zu fördern. Wir haben digitale Tools wie das Online-Wörterbuch dicod’Òc, den Verbkonjugator verb’Òc und Natural Language Processing (NLP) Tools entwickelt.

Vincent Gleizes: Ich bin 25 Jahre alt und lebe in Frankreich. Ich bin Student der Informatik und spezialisiere mich auf Datenentwicklung und -organisation. Ich habe auch einen Bachelor-Abschluss in Okzitanisch gemacht, was mich zu einem Praktikum bei Lo Congrès führte, um zwei meiner Leidenschaften zu verbinden.

Aure Séguier: Und ich bin Aure Séguier, Projektmanager für die Verarbeitung natürlicher Sprachen beim Kongress.

Mit welchen sprachbezogenen Daten arbeiten Sie und zu welchem Zweck?

Wir arbeiten mit Daten, die zur Entwicklung von Werkzeugen im Bereich der natürlichen Sprachverarbeitung verwendet werden. Zum Beispiel haben wir ein- und zweisprachige Wörterbücher, die in TEI formatiert sind, Lexika der Konjugationen, Textkorpusse…..

Warum haben Sie sich entschieden, okzitanische Wörter in Wikidata zu importieren?

In einigen Jahren werden die formalen Verarbeitungswerkzeuge des Okzitanischen fertiggestellt sein. An dieser Stelle wird es notwendig sein, sich auf die semantische Analyse zu konzentrieren. Dazu müssen jedoch die Worte unserer Sprache mit Begriffen verknüpft werden, die für den Computer verständlich sind. Occitan verfügt nicht über die personellen und finanziellen Ressourcen, um eine Konzeptbasis von Grund auf neu aufzubauen. Glücklicherweise gibt es Wikidata, das völlig kostenlos genutzt werden kann. Indem wir okzitanische Lexeme zu Wikidata hinzufügen und mit Konzepten verknüpfen, bieten wir okzitanischen NLP-Akteuren die Möglichkeit, Werkzeuge zu entwickeln, die an der Bedeutung eines Textes arbeiten, wie Chatbots, Textzusammenfassungswerkzeuge, persönliche Assistenten.

Wie sind Sie vorgegangen? Was waren die verschiedenen Schritte?

Vincent: Der erste Schritt war, sich mit der Wikidata-API, dem lexikografischen Datenorganisationsmodell und der allgemeinen Funktionsweise von Wikidata vertraut zu machen. Ziel war es, zu wissen, wie man die Daten von Lo Congrès reorganisiert, um sie mit dem Datenmodell von Wikidata abzugleichen. Dann stellte sich die interessante Frage: Wie können diese Daten integriert werden, welche API-Funktion ist für jede Funktionalität des Importskripts zu verwenden? Wie kann man überprüfen, ob die Anfragen gut funktioniert haben? Wie haben die anderen Mitwirkenden diese oder jene Informationen geteilt?

Zusammen mit der ersten Aufgabe mussten wir über das Konzept nachdenken, wie das Importskript funktionieren sollte, den Hauptalgorithmus schreiben und Grundfragen klären, wie: “Anhand welcher Merkmale stellen wir fest, ob zwei Lexeme identisch sind?” Dann schrieb ich die Skriptfunktionen und, nachdem ich sie separat getestet hatte, den Algorithmus selbst.

Der letzte Schritt war eine Reihe von Tests/Korrekturen in der Testumgebung von Wikidata, um den kleinstmöglichen Fehler hervorzuheben. Und schließlich Testphasen, die der Wikidata-Community vorgestellt wurden.

Was haben Sie während des Prozesses erlebt, was ist gut gelaufen, welche Probleme sind Ihnen aufgefallen?

Vincent: Insgesamt verlief das Projekt sehr gut. Ich würde sagen, dass alles gut funktionierte, und doch war es nicht einfach: Ich musste einen Bot (Skript) in einer Sprache schreiben, die ich überhaupt nicht kannte, und ich musste die Daten aus Dateiformaten extrahieren, mit denen ich noch nie zuvor gearbeitet hatte. Ich hätte nicht gedacht, dass ich ein Programm nach einem Monat (der Dauer meines Praktikums) funktionsfähig machen könnte. Aber zum Glück konnte ich um mich herum Hilfe und gute Ratschläge erhalten, die es mir erlaubten, in einem guten Tempo voranzukommen.

Das Hauptproblem, auf das ich stieß, war vor allem meine mangelnde Kenntnis von Wikidata, seiner API und Dokumentation. Ich saß oft mit Fragen wie, „wie erhält man diese Informationen zurück?“ oder „warum funktioniert diese Anfrage nicht?“ fest, bis ich mich traute nachzufragen, und jedes Mal kriegte ich eine ganz klar verständliche Antwort von Mitgliedern der Wikidata-Community.

Was sind die nächsten Schritte, wie werden Sie mit Wikidata & Sprachen weiterarbeiten?

Aure: Sobald die Lexeme importiert sind, müssen sie mit den Konzepten verknüpft werden, die sie repräsentieren. Dies erfordert das Engagement der ehrenamtlichen Community, da keine unserer Partnerorganisationen über genügend Personal verfügt, um ein solches Projekt durchzuführen. Um eine solche Aufgabe attraktiv zu machen, muss sie spielerisch dargestellt werden. Vielleicht über eine mobile Anwendung wie ein Spiel?

Was könnten Sie dank der importierten Daten tun? Welchen Nutzen könnte man daraus ziehen?

Aure: Sobald die Lexeme mit den Konzepten verknüpft sind, können wir uns alles vorstellen. Wikidata wird helfen, die Bedeutung von Wörtern zu erkennen. Wenn ich zum Beispiel sage, dass ich „eine Maus für meinen Computer“ von einem Programm kaufen möchte, sucht es nach dem Begriff, der mit dem Wort „Maus“ verbunden ist. Die Software wird zwei finden und sich ansehen, welches mit einem anderen Konzept verbunden ist, das mit dem Wort „Computer“ verbunden ist. Das wird das Programm entsprechend wissen lassen, dass ich keine Labormaus kaufen will.

So können wir Werkzeuge entwickeln, die Texte zusammenfassen, Dokumente nach Themen klassifizieren, Fragen eines Benutzers automatisch beantworten… oder sogar einen intelligenten persönlichen Assistenten, damit Smartphones auch Okzitanisch sprechen können!

Interview zusammengestellt von Léa Lacroix, Nicolas Vigneron und Jens Ohlig.