Wikipedia – a place for encounters and creativity, diversity and equality

Claudia Bergmann

20. May 2021

Millions of people around the world use Wikipedia – to educate themselves, to look something up, to research facts. They rely on all the information and details being up-to-date, unbiased and correct. Twice a year, #1lib1ref (one librarian, one reference) calls librarians around the world to add missing references, sources, and bibliographical references to Wikipedia articles and thus improve the quality of the more than 300 language versions of Wikipedia.

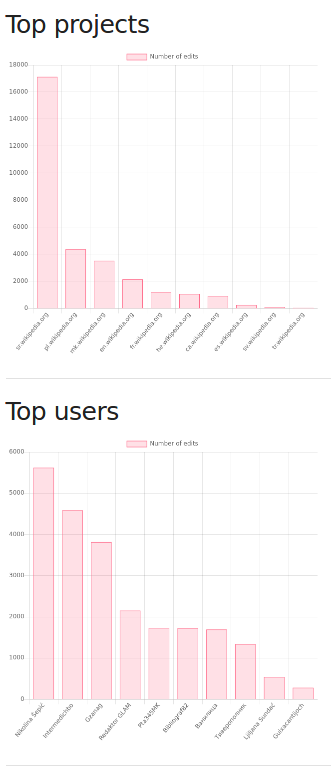

In early 2021, #1lib1ref took place for the sixth time – one language version and one user stood out. In the Serbian-language Wikipedia, there were 17,132 edits and 5,620 of those were made by one single person alone, Nikolina Šepić!

She has added by far the most references, worldwide! A few days ago we were able to talk to her about this commitment. Nikolina told us how she became involved in Wikipedia, about her motivation to join the #1lib1ref campaign and the motivation behind her commitment to Wikipedia in general.

Nikolina Šepić has been active in the Serbian-language Wikipedia since November 2018. The student of pedagogy at the University of Belgrade added 5,620 edits during the 2021’s campaign of #1lib1ref in January/February, contributing the most references, locally and globally.

Wikipedia – more than an encyclopedic internet project with free content

Nikolina, how did your connection with Wikipedia start? Why did you decide to volunteer to the project?

I started editing Wikipedia on November 7, 2018, within the workshop Knowledge against human trafficking, at the Faculty of Philosophy in Belgrade organised by Wikimedia Serbia in cooperation with the Unitas Fund, the Red Cross and the Center for Career Development of the Faculty of Philosophy. I gained additional knowledge and experience in 2019 as part of an internship at Wikimedia Serbia, as an associate.

Imagine a world in which every single person on the planet is given free access to the sum of all human knowledge

Looking back at the two and a half years you have been editing Wikipedia so far, you have been very active in various projects. We would love to hear how you have become so passionate – does this have to do with your studies?

The quote from Wikipedia’s founder, Jimmy Wales, and the motto of many Wikipedia editors, like mine, is: “Imagine a world in which every single person on the planet is given free access to the sum of all human knowledge. That’s what we’re working on.” As it can be noticed, this thought is connected to education, and therefore to my studies, considering that I study at the University of Belgrade, Faculty of Philosophy, majoring in pedagogy.

How did you get into #1lib1ref and when did you decide to participate?

My initial wish was to support the campaign and its organiser, Gorana Gomirac, manager for cooperation with cultural institutions [Wikimedia Serbia], and later I liked the most that I learned a lot of information that I didn’t know, but I was interested in. I started setting goals for myself in the hope of entering the top ten, the top five. I didn’t expect to be a winner locally, let alone globally. I am pleasantly surprised by the victory and I am very glad about that.

You have made an incredible amount of edits in just three weeks. Can you tell us a little bit about how that started? Was there any kind of organised workshop?

Yes, in accordance with the epidemiological situation, the workshop was held via Zoom, but due to university obligations, I did not have time to attend. Also, the obligations regarding the faculty and preparing for the exams affected the amount of references I entered. I tried to dedicate every free moment to the campaign of editing references because I think it is extremely important. That way the articles become more verifiable and reliable. I was surprised by the number of articles that do not contain any or too few references.

Wikipedia – a place for encounters and creativity, for self-confidence, diversity and equality

What does Wikipedia mean to you personally?

For me, Wikipedia is not only an encyclopedic project of free content on the internet and the main source of information, but also a space for volunteering, productive use of time, and initiation. A place of new acquaintances, meetings of wonderful people, development of creativity, creativity, self-confidence, respect for diversity and equality.

Thanks a lot for the interview!