Künstliche Intelligenz und Wikipedia

Wie verändert KI das Weltwissen und unseren Zugang dazu?

WMDE allgemein

22. Juni 2023

Künstliche Intelligenz (KI) hat seit der Veröffentlichung von ChatGPT Ende 2022 einen großen Einfluss auf unseren Alltag. Auch für Wikipedia und andere Wikimedia-Projekte spielt KI eine wichtige Rolle. Zum Beispiel hilft künstliche Intelligenz dabei, Vandalismus in der Online-Enzyklopädie zu bekämpfen, und Sprachassistenten wie Siri und Alexa nutzen Informationen aus Wikipedia und Wikidata. Doch wie realistisch ist es, dass wir in Zukunft Chat-Programme statt Wikipedia um Informationen bitten? Wie verändert sich dadurch das Wissen in Wikipedia? Und besteht die Gefahr, dass wir kritische Medienkompetenz und den Umgang mit Quellen vernachlässigen?

KI dringt immer stärker in unseren persönlichen Bereich ein und wirft damit neue rechtliche, politische und moralische Fragen auf. Wikimedia Deutschland beobachtet und begleitet diese Debatten genau, insbesondere in Bezug auf die Herausforderungen, denen Wikipedia und andere offene Wissensquellen im Internet gegenüberstehen, und wie wir ihnen am besten begegnen können. Am 16. Juni 2023 haben wir mit kompetenten Gästen dazu diskutiert. Und viele Interessierte waren vor Ort in der Geschäftsstelle oder per Livestream dabei.

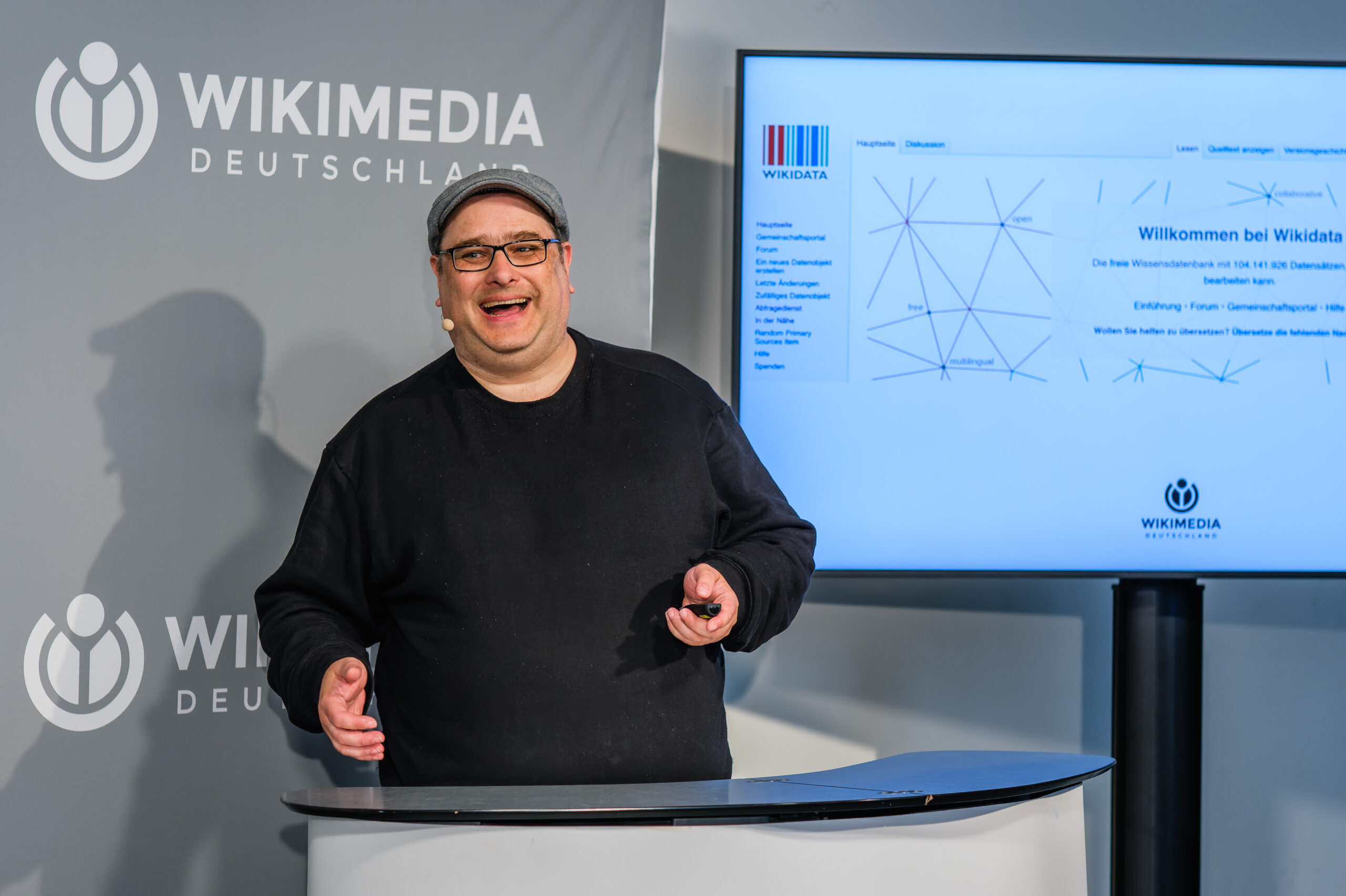

Der fachliche Input wurde zunächst von Jens Ohlig, einem Mitglied des Präsidiums von Wikimedia Deutschland e.V. und Redakteur bei Tagesspiegel Background Cybersecurity und Background Digitalisierung & KI, geliefert. Er erklärte den Zuhörern auf eine verständliche Weise, wie KI funktioniert und warum künstliche Intelligenz noch weit von menschlicher Intelligenz entfernt ist.

Ein großes KI-System, das dem Gemeinwohl dient

Jens Ohlig betonte, dass die Zukunft eines positiven Internets darin liegt, viele offene Daten zu schaffen, die von KI als Grundlage genutzt werden können – ähnlich wie es Wikidata bereits seit vielen Jahren als offene Wissensdatenbank tut. Wenn eine KI auf Wahrscheinlichkeiten basiert und nicht auf Fakten, besteht die Gefahr, dass Vorurteile und Stereotype bedient und weiterverbreitet werden. Ein Beispiel dafür ist, wenn ein Algorithmus in den USA entscheidet, welcher Insasse länger im Gefängnis bleiben muss und wer entlassen wird. Wenn die KI gelernt hat, dass in den USA mehr Menschen mit schwarzer Hautfarbe im Gefängnis sind, könnte sie laut ihrer Logik die Hautfarbe als Kriterium dafür ansehen, warum jemand im Gefängnis sitzt.

Das Unternehmen OpenAI, das sich auf die Entwicklung und Bereitstellung von fortschrittlichen KI-Modellen und -Technologien spezialisiert hat und für Sprachmodelle wie ChatGPT verantwortlich ist, trägt zwar „open“ im Namen, ist aber ein verschlossenes System. Daraus ergibt sich die große Frage: Wer kann sich das Training eines KI-Modells leisten und wer hat Zugriff drauf? Sollte es nicht lieber ein großes KI-System geben, das dem Gemeinwohl zur Verfügung steht? Aber wie wäre dieses realisierbar? Stellt der Staat das Rechenzentrum zur Verfügung? Woher kommen die offenen Daten, mit dem so eine KI angelernt wird?

Die Fähigkeit, Quellen zu bewerten, wird immer essentieller

Im anschließenden Panel sprachen dann Dr. Christiane Rohleder, Staatssekretärin im Bundesministerium für Umwelt, Naturschutz, nukleare Sicherheit und Verbraucherschutz, Markus Beckedahl, Journalist und Gründer von netzpolitik.org, sowie Franziska Heine, Geschäftsführende Vorständin von Wikimedia Deutschland e.V. zu den Risiken und auch Chancen von KI für Wikipedia und das Weltwissen.

Rohleder betonte die Tatsache, dass die meisten Jugendlichen Social Media als ihre Hauptinformationsquelle angeben. Daher wird es immer wichtiger, das Bewertung von Quellen bereits in der Schule zu lehren. Leider wird dies derzeit noch zu wenig getan, da es auch kein Teil der Ausbildung für Lehrende ist. Doch eine unabhängige Bewertung von Informationen ist entscheidend, insbesondere wenn Quellen, wie es derzeit bei ChatGPT der Fall ist, nicht offen gelegt werden.

Markus Beckedahl stimmte dem zu und stellte die Frage, wie es möglich sei, die Mehrheit der Gesellschaft zu erreichen und ihnen zu vermitteln, wie Trainingsdaten für KI-Systeme erhoben werden und ob man ihnen vertrauen kann. Hierfür wären bedeutende Investitionen in solche Programme erforderlich.

Selbst etwas beitragen statt nur zu konsumieren

Franziska Heine sieht eine Gefahr darin, dass Zwischensysteme wie Alexa und ChatGPT die Menschen zu reinen Konsumenten machen und sie ihrer Mündigkeit berauben. Die Menschen wissen nicht, woher ihre Informationen stammen und dass sie selbst über Wissen verfügen und einen Beitrag leisten können. Langfristig untergraben diese Systeme sogar die Quellen selbst.

Es gab auch Kritik an der Politik und der aktuellen EU-Regulierung von KI. Markus Beckedahl merkte dazu an: „Das, was gerade verhandelt wird, wird erst 2026 in Kraft treten. Dann braucht es wiederum 2 bis 3 Jahre für Iterationen. Das ist im Technologiebereich viel zu langsam, man kann keine Gesetzgebung auf Sicht fahren. Es sollte zuerst eine Kennzeichnungspflicht für Inhalte geben, die von KI erstellt wurden, und das sollte schnell politisch durchgesetzt werden.“

Neben den Risiken auch die Chancen sehen und Fehler zulassen

Natürlich bieten die neuen Technologien auch viele Chancen, wie das Publikum an diesem Abend betonte. Beispiele dafür sind vielfältig: die Rede zum 80. Geburtstag des Großvaters, Bots zur Automatisierung von E-Mails oder eine bessere Lesbarkeit von Texten, einschließlich Wikipedia-Artikeln. KI kann in diesen Bereichen äußerst nützlich sein. Es wurde auch angemerkt, dass kommerziellen Anwendungen die Chance gegeben werden sollte, Fehler zu machen und sich weiterzuentwickeln, anstatt sofort strenge Regulierungen zu fordern. Wikipedia hätte vor 20 Jahren auch diese Chance gehabt.

Es gibt viele unterschiedliche Meinungen zu diesem Thema. Was wäre also die Lösung? Franziska Heine meint: „Der Schlüssel liegt in der Kombination von Mensch und Technik, so wie wir es bereits in unseren Wikimedia-Projekten praktizieren. Natürlich sind Automatisierungstools wichtig, um den Menschen zu unterstützen. Aber sie dürfen nicht wie Blackboxes existieren. Das ist meiner Meinung nach die einzige Antwort darauf.“

Gut, wenn KI zur Identifizierung & Vermeidung von möglichen In-Group-Biases und Interessenkonflikten in der Wikipedia eingesetzt werden kann. Weiters dazu in meinem Profil und auf der Disk. Danke, Daniel (Benutzer:Dankedaniel)

Eine Kennzeichnungspflicht oder eine Signatur des Herstellers wäre wirklich nötig. Da die Konstrukteure des Programms so fit im Programmieren sind, könnten sie bestimmt eine Markierung anbringen, welche von Interessierten erkannt würde. Wissen wir, ob das nicht bereits geschieht? Und naürlich muß sich in den Schulen etwas ändern, damit die Kinder und Jugendlichen kritischer werden können.